Archives

Ces pages furent créées dans le passé et je ne veux ni les diffuser, ni les effacer.

Journaliste Jugement Livre et édition Québec

Les nouvelles et l’utilisation équitable

Olivier Charbonneau 2017-09-28

Un collègue m’as mis la puce à l’oreille d’un jugement récent concernant l’utilisation équitable et la communication de nouvelles. Cedrom-SNI, La Presse, Le Devoir et Le Soleil ont obtenus une injonction interlocutoire contre un site qui moissonnait les titres et amorces d’articles afin de les rediffuser soit gratuitement son site, soit sous un abonnement payant. Voici le lien vers la cause:

Cedrom-SNI inc. c. Dose Pro inc., 2017 QCCS 3383 (CanLII), <http://canlii.ca/t/h50zb>, consulté le 2017-09-28

Je vous invite à lire ce sommaire de Julie Desrosiers, Chris Semerjian et Patricia Hénault chez Fasken Martineau. J’apprécie leur effort mais je suis un peu déçu qu’ils indiquent que cette « décision a de nombreuses implications dans la reconnaissance et l’étendue des droits d’auteur au Québec. » En fait, comme le précise le juge au paragraphe 23:

[23] Le Tribunal doit garder à l’esprit que le remède demandé est analysé en l’absence d’une preuve complète et qu’il doit éviter de se pencher sur la question comme s’il s’agissait d’un procès au fond. C’est ce que la Cour d’appel soulignait dans l’arrêt Morrissette c. St-Hyacinthe (Ville de)[9] :

Et, au paragraphe 48:

[48] (…) La question de déterminer s’il s’agit d’une portion importante du texte de l’article demeure une question pour le juge du fond.

À tout le moins, l’implication réelle de ce jugement concerne le recours aux injonctions dans un contexte de contrefaçon. Je ne veux pas minimiser la rigueur du travail de l’honnorable juge Duprat ou le travail des avocat.e.s travaillant sur le dossier. Je veux simplement contextualiser, pour le public, (et certains de mes lecteurs), les divers moyens procéduraux de la cour – tous les jugements n’ont pas le même poids. Il ne s’agit d’un prélude à une analyse plus approfondie de la question en droit.

Ceci dit, la conséquence pour le moissonneur de site de nouvelles est évident : il s’est fait couper l’herbe sous le pied (le jeu de motsest voulu). Sans source pour opérer son service et générer un revenu, il faut se demander s’il aura les moyens (pécuniers) pour se rendre à la prochaine étape…

Peut-être que d’autres seront de la partie ? Comme le précise le juge, encore au paragraphe 48:

Il faut soupeser le fait que ce type d’informations (titre et amorce ou simplement titre) est relayée en des millions d’occasions par des sites comme Google ou Yahoo.

Livre et édition Pétition Québec Utilisation équitable

Why I’m withdrawing from Copibec’s class-action suit against Université Laval (traduction)

Olivier Charbonneau 2017-09-22

(English post will start just after this blockquote.)

FR: Voici une traduction effectuée par l’Association canadienne des professeures et professeurs d’universités (dont je suis membre) du billet diffusé le 8 septembre 2017, intitulé « Pourquoi je vais me retirer du recours collectiv de Copibec contre l’Université Laval »

EN: This is a translation by the Canadian Associaiton of University Teachers (of which I am a member) of a post I wrote on September 8th on this blog.

As the author of published works, I qualify as a party to the class-action lawsuit brought by Copibec against Université Laval. That said, I plan to sign the opt-out form that will remove me from the class action and send it to both the registrar of the court and Copibec’s mailing address before October 15.

I’d like to put forward some of the reasons behind my decision, and which I hope will stand in support of Université Laval.

Before I continue, I invite the rest of the university community to join me in withdrawing from the class-action suit. All you need to do is complete the form provided on Copibec’s website and send it to the court clerk. The mailing address is on the form:

http://copibec.ca/medias/files/Action_collective/Formulaire-exclusion.pdf

I have two reasons for opting out: 1) the suit ignores the business realities of the academic setting and 2) it constitutes a severe breach of academic freedom and intellectual freedom, which are intertwined with freedom of expression.

1. Business realities of academic publishing

Despite Copibec’s complaints against Laval, in 2014-15, the institution spent $12.6 million on documents for its library, surpassed only by McGill University ($18.9 million).

Here’s a broader context: Quebec universities as a whole spent more than $63 million on library acquisitions, whereas the grand total for universities across Canada stands at $311 million. Public libraries in Quebec dished out roughly $30 million, and Quebec households bought more than $1 billion in books, newspapers and magazines. In 2012-13, more than two thirds of these expenditures (70% in Quebec) were for digital collections. What’s more, because digital sources now gobble up such a huge portion of annual acquisition budgets, the BCI no longer distinguishes between print and digital in its annual statistics.

The basic difference between a print collection and a digital one is easy to understand. Digital collections are acquired under a licence agreement that specifies usage rights, such as photocopying the material and sharing it with students through learning management systems. Print collections are governed by copyright law and by the licences of copyright-management collectives. Over the past few years, scientific publishers have in fact offered digital bundles for collections that institutions already have in hard-copy format—especially for scientific journals. Yes, university libraries have repurchased a significant portion of their existing print collections in digital format.

As a result, the proportion of print material(requiring a Copibec licence) of regular acquisitions is dwindling in the average Québec university library. In contrast, digital acquisitions, which require a licence similar to what Copibec offers, are booming. This new reality means that access rights, introduced by the Harper government in 2012 , are bundled, through licences, with digital works.

In fact, consumers of digital content are in the same boat: all platforms offering copyright-protected works in digital format always do so after having agreed to a digital licence. Reading a book on Kindle? You’ve said yes to Amazon. Same thing for Netflix, iTunes, Google Play, Steam… Consumers can simply glance over the terms of these licences but information professionals – your librarians, library technicians and clerks behind the scenes–well, they read and negotiate them on your behalf.

Let’s summarize the situation using the following equation, regardless of format or type of content:

Use = document + rights

In the print world, the equation was as follows:

Course packs sold to students = a university library’s print collection + Copibec licence

In the world of digital scholarly publishing, the reality that I experience and have studied is:

Use = digital document directly from the publisher + usage licence directly from the publisher

(Remember that libraries have transitioned to digital collections and acquire these in massive numbers.)

Note that without the publisher’s licence, it’s IMPOSSIBLE to acquire a digital resource. You don’t have to be a rocket scientist to understand that, for the average Quebec university, a licence with Copibec IS WORTH NEXT TO NOTHING. Why? Because the percentage of works offered in our licensed collections (that is, digital) is skyrocketing.

What’s more, I think Université Laval is one of the only Quebec universities to have done any rigorous “library economics” homework. All of the other universities in the province are passing along the cost of Copibec’s licence to their students, through ancillary fees, so they don’t see the urgency of challenging the current copyright orthodoxy.

If I were so bold as to summarize Copibec’s position, the fundamental equation for library-based access to works would be as follows:

Use = document comes from who knows where, and maybe from what’s left in the paper collection + copyright infringement through the fair dealing exception.

This assertion comes from a fairy tale that doesn’t reflect what I experience at work every day. My doctoral research, based on empirical analyses, confirms what I’m seeing at work.

Indeed, resorting to the principle of “fair dealings” is itself an exception, and to get back to the rocket-scientist analogy, a diligent and reasonable rights holder would immediately grasp its clients’ interest for digital material and put forward a palatable solution… Digitizing a work costs money. Consider all of the universities that digitize works on the fly to tap into the concept of fair dealings as an exception to copyright. The copyright holder could digitize everything in one fell swoop and sell the same copy to every university … around the world! That’s one of the secret formulas of the world’s biggest academic publishers.

If the Canadian government adopted a full slate of exceptions in the 2012 Copyright Act, it also assigned a new right to rights holders: making material available online. Quebec’s universities, especially Laval, diligently kept pace with the world of academic publishing in embracing digital formats. I don’t think Laval is at fault here, but I do think that Copibec, in reality, is defending a sort of commercial sloth. In addition, I believe the cultural sector is transposing its own reality on that of academia. The market failures and externalities of one sector are not the same as in others, even though copyright governs them all.

In fact, it would be more relevant to consider fair dealings as the public sector’s investment in mastering the workings of the markets and of the social systems generated by the digital world. University libraries, together with professors, students, techno-educators and other partners, are analyzing the needs of their clienteles and are trying to establish economic and social systems around digital works. We then transfer this knowledge to the industry through negotiated licence agreements or through exceptions. In both cases, opportunity knocks for whoever understands the message and adjusts accordingly. Copibec should put forward a business deal that considers our needs—suing libraries points to a woeful misunderstanding of the powerful trends affecting university markets and the academic publishing sector.

What happened to the horse when the automobile was invented…? Darwin and Shumpeter can shed some light on that.

This isn’t only my professional assessment of the situation, but also the conclusion of my doctoral thesis (which I’ll be defending on September 15).

2. Academic and intellectual freedom: integral parts of freedom of expression

I developed the link between academic and intellectual freedom and freedom of expression in a book chapter dealing with open access, available at Concordia University’s Research Repository, and which was published in the Handbook of Intellectual Freedom. All of the authors of this work won awards for their contributions from the Intellectual Freedom Round Table of the American Library Association. Here is an excerpt from my chapter:

There is a clear consensus in the literature that intellectual freedom is directly linked with freedom of expression, the press and to access and use information and that it is a core value of librarianship. Gorman famously stated that:

“In the United States, [intellectual freedom] is constitutionally protected by the First Amendment to the Constitution, which states, in part, ‘Congress shall make no law respecting an establishment of religion or prohibiting the free exercise thereof; or abridging freedom of speech, or of the press.’ There is, of course, no such thing as an absolute freedom outside the pages of fiction and utopian writings, and, for that reason, intellectual freedom is constrained by law in every jurisdiction.” (2000, p. 88)

Gorman continues to state that rarely are proponents “for” or “against” intellectual freedom, but they articulate their views in absolute or relative terms. On these issues, Hauptman (2002 pp. 16-29) as well as and McMenemy, Poulter and Burton (2007) offer additional evidence and insight. The link between intellectual freedom and censorship is obvious.

Intellectual freedom is also linked with Article 19 of the United Nation’s Universal Declaration of Human Rights, which states:

“Everyone has the right to freedom of opinion and expression; this right includes freedom to hold opinions without interference and to seek, receive and impart information and ideas through any media and regardless of frontiers.” (1948)

Samek (2007, pp. 9-11) provides an account of how various groups, such as United Nations Educational, Scientific and Cultural Organization (UNESCO) and the International Federation of Library Associations and Institutions (IFLA) have further articulated the concept of intellectual freedom in various initiatives and declarations.

Barendt offers an interesting distinction between academic freedom, a well-known right professors enjoy in universities, and intellectual freedom:

“[a] cademic freedom is not identical to intellectual freedom or to freedom of the mind. Intellectual freedom is a right to which we are all entitled, wherever we work. Like freedom of speech or expression, it is a general right belonging to all citizens.” (2010, p. 38)

In discussing how intellectual freedom and freedom of expression are intertwined, Krug further articulates, in light of librarianship, that:

“All people have the right to hold any belief or idea on any subject and to express those beliefs or ideas in whatever form they consider appropriate. The ability to express an idea or a belief is meaningless, however, unless there is an equal commitment to the right of unrestricted access to information and ideas regardless of the communication medium. Intellectual freedom, then, is the right to express one’s ideas and the right of others to be able to read, hear or view them.” (2006, p. 394-5)

From these points, we can draw a common thread for intellectual freedom, namely that it is universal in enshrining our right to access and use information. In light of this, intellectual freedom intersects or overlaps with open access in that the former is promoted as a way to maximize or optimize access to and use of digital documents and information, while the latter expresses a fundamental right of the same vein.

I believe that Copibec’s suit, despite its legality from a strictly legal point of view, illegitimately and inordinately undermines our fundamental rights.

3. Supporting statistics

—In 2014-15, Québec universities spent just under $70 million on library acquisitions (source: BCI).

—Canadian university libraries spent more than $311 million on acquisitions (source: CARL/ABRC 2014/15).

—In comparison, Québec households spent $657 million on books ($3 billion across Canada) and $417 million on newspapers and periodicals (just under $2 billion across Canada) in 2015 (source: Statistics Canada. Table 384-0041 – Detailed household final consumption expenditure provincial and territorial – annual (dollars)) CANSIM (socioeconomic data base). Site consulted on September 7, 2017.

—Percentage of acquisitions in digital format: 2012-2013 was the last year in which the library sub-committee of the Bureau de coopération interuniversitaire distinguished between digital and print acquisitions, with roughly three quarters of expenditures going to digital at the time. That proportion has increased steadily since (take my word for it, a librarian with more than 14 years’ experience).

4. Sources

Barendt, E. M. 2010. Academic freedom and the law: A comparative study. Oxford; Portland, Or.: Hart Pub.

Gorman, Michael. 2000. Our enduring values: Librarianship in the 21st century. Chicago: American Library Association.

Hauptman: forward of Buchanan, Elizabeth A., and Kathrine Henderson, eds. 2009. Case studies in library and information science ethics. Jefferson, N.C.: McFarland & Co.

Krug, Judith F. 2006. Libraries and the Internet. Chap. 7.3, In Intellectual freedom manual, ed. Office for Intellectual Freedom. 7th ed., 394. Chicago: American Library Association.

McMenemy, David, Alan Poulter and Paul F. Burton. A handbook of ethical practice: a practical guide to dealing with ethical issues in information and library work. Oxford: Chandos, 2007.

Samek, Toni. 2007. Librarianship and human rights: A twenty-first century guide. Oxford, England: Chandos.

Canada Droit d'auteur Pétition Réforme

Abolir le droit d’auteur de la couronne: signez la pétition avant le 23 septembre

Olivier Charbonneau 2017-09-19

Il ne reste que quelques jours avant la clôture de la période de signature de la pétition e-1116, enjoignant le gouvernement fédéral d’abolir le droit d’auteur de la couronne. Le quoi? Le droit d’auteur de la couronne est le nom que l’on donne au droit satutaire (à l’art. 12 de la Loi sur le droit d’auteur) quand le droit d’auteur appartient à Sa Majesté.

12 Sous réserve de tous les droits ou privilèges de la Couronne, le droit d’auteur sur les oeuvres préparées ou publiées par l’entremise, sous la direction ou la surveillance de Sa Majesté ou d’un ministère du gouvernement, appartient, sauf stipulation conclue avec l’auteur, à Sa Majesté et, dans ce cas, il subsiste jusqu’à la fin de la cinquantième année suivant celle de la première publication de l’oeuvre.

- L.R. (1985), ch. C-42, art. 12; 1993, ch. 44, art. 60.

C’est-à-dire que tous les gouvernements du Canada possède un droit d’auteur spécial sur tous les écrits, images, cartes, etc. produites par ses fonctionnaires et les contractuels y oeuvrant (si leur contrat de travail est silencieux quant à la titularité du droit d’auteur.

Ironiquement, le site officiel des publications du Canada indique que la gestion du droit d’auteur de la couronne revient aux départements et entités spécifiques – ce qui créé un joli bordel quand nous désirons créer une collection de documents numériques en bibliothèque. Voici le joli texte évoquant un casse-tête pour les canadiennes et les canadiens, enseignants, élèves, entrepreneurs, scientifiques et bidouilleurs:

Depuis le 18 novembre 2013, Éditions et Services de dépôt n’est plus responsable de l’administration du droit d’auteur de la Couronne et l’octroi de licences au nom des ministères et organismes du gouvernement du Canada. Les Canadiens et Canadiennes doivent communiquer directement avec les ministères auteurs pour toute question relative au droit d’auteur de la Couronne et l’octroi de licences.

Certains ministères et organismes ont fourni des points contact spécifiques aux demandes d’affranchissement du droit d’auteur reliées à leur matériel. Si vous êtes incapable de trouver une organisation dans la liste des points de contact fournie ci-dessous, veuillez consulter la liste des ministères et organismes du gouvernement du Canada sur le site Web du Canada.

La solution? signez la pétition pour abolir le droit d’auteur de la couronne:

À l’origine de changements sociaux positifs se trouvent à la fois des actions énergiques menées sur de grands enjeux, et des avancées graduelles sur des aspects techniques, mais qui n’en sont pas moins importants.

La campagne sur la réforme du régime de droits d’auteur de la Couronne est une de ces avancées, et a besoin de votre aide!

Les droits d’auteur de la Couronne sont basés sur la prétention du gouvernement selon laquelle les œuvres produites par les fonctionnaires, le Parlement, les ministres ainsi que les ministères et organismes lui appartiennent. Dans sa forme atuelle, ce régime empêche le public d’accéder à une multitude de documents publics produits par le gouvernement. Il existe une solution simple : l’abolir. Une pétition électronique à la Chambre des communes poursuit cet objectif, et prendra fin la semaine prochaine. Nous vous exhortons de la signer.

https://petitions.noscommunes.ca/fr/Petition/Details?Petition=e-1116

Paul Jones

ACCPU / CAUT

Comme de raison, je suis fier de figurer parmi les signataires de cette pétition.

LLD

Texte de ma soutenance doctorale

Olivier Charbonneau 2017-09-15

Mesdames, messieurs,

Membres du jury de thèse,

Avant toute chose, permettez-moi de souligner que les terres qui nous entourent font partie du territoire traditionnel non cédé des Kanien’keha:ka (dénommés également Mohawks), qui a longtemps servi de lieu de rassemblement et d’échange entre les nations. Je remercie de tout mon cœur les anciens de toutes les nations autochtones pour leur bienveillance.

Je me présente humblement devant vous afin de défendre ma thèse doctorale en droit, en vue de l’obtention du grade de Legum Doctor de l’Université de Montréal.

J’ai débuté mon long parcours en droit en 2004 au certificat, en cours du soir, à notre faculté. Nouvellement embauché comme bibliothécaire à l’Université Concordia, je devais bâtir un programme de recherche en sciences de l’information afin d’obtenir ma permanence à titre de membre du syndicat des professeurs.

À cette époque, nourrit par le feu d’une jeunesse qui s’étiole maintenant, je soupçonnais qu’il était urgent de réparer le droit d’auteur pour sauver les bibliothèque d’un destin numérique incertain. En plus d’études en droit, je me suis impliqué dans une panoplie de comités professionnels sur le droit d’auteur au Québec, au Canada et à l’international. J’ai monté des campagnes d’information, écrit des mémoires à diverses instances parlementaires et j’ai participé à d’innombrables réunions, conférences et autres entrevues. Malgré tous ces efforts, je constatais une lacune, un vide théorique en droit et en bibliothéconomie qui limitait une conceptualisation harmonieuse du droit d’auteur numérique et des bibliothèques.

Éclairé maintenant par une sagesse qui s’est focalisée grâce à vous, je constate que le droit d’auteur n’est pas brisé, mais que les bibliothèques permettent l’émergence de nouvelles normativités dans les systèmes économiques et sociaux d’œuvres numériques protégées par le droit d’auteur. Je suis ici pour défendre cette thèse, suite à ce long cheminement personnel et intellectuel.

D’ailleurs, vous pouvez revivre mon parcours depuis 2005 à travers les 2264 billets versés dans mon carnet de recherche qui est maintenant hébergé par le Centre de recherche en droit public, à l’adresse culturelibre.ca. Le texte de ma soutenance y est d’ores et déjà disponible.

D’ailleurs, pour respecter le décorum de cette assemblée et le ton de ma thèse, je vais poursuivre cet exposé à la 1ère personne du pluriel.

Dans notre thèse, nous nous intéressons aux utilisateurs finaux d’œuvres protégées – et surtout – ceux et celles qui utilisent du contenu numérique protégé par droit d’auteur en bibliothèque. De plus, notre étude se situe à un moment où le numérique introduit de sérieuses pressions sur les régimes du droit d’auteur, pressions qui se manifestent par des technologies nouvelles, la mondialisation des marchés et des revendications sociales en lien avec ces mutations. Nos recherches tombent à point nommé vu les divers litiges en lien avec l’utilisation équitable, dont ceux déposés à la Commission du droit d’auteur ces dernières années, certains ayant été portés en appel jusqu’à la Cour suprême. Plus récemment, évoquons rapidement la qualification du recours collectif lancé par Copibec contre l’Université Laval ainsi que le jugement récent contre l’Université York. Il semble que les parties requérantes invoquent le resquillage des bibliothèques et les placent dans le rôle du truand. Est-ce vraiment le cas ?

Il est primordial de saisir l’importance du numérique dans les collections des bibliothèques universitaires québécoises. Tel qu’indiqué à la figure 2 de la page 196, en 2011-2012, les dépenses totales de toutes les bibliothèques affiliées à des universités membres de l’ancienne CRÉPUQ frisent les 70 millions de dollars, dont environ 77% est alloué à des ressources électroniques. La balance, environ 15 millions de dollars, sert à l’achat de documents papiers, qu’ils s’agissent de livres ou de périodiques. En fait, l’année 2006-2007 est la première année où les bibliothèques québécoises ventilent leurs dépenses en fonction du format, numérique ou papier. À ce moment, les dépenses pour le numérique dépassent déjà les montants consacrés aux documents papier. Le numérique s’impose donc dans les pratiques d’acquisition documentaires des bibliothèques universitaires québécoises. La réalité professionnelle des dernières années en est donc une où le numérique prend la part du lion de nos budgets d’acquisition documentaire. Comment réconcilier cette réalité professionnelle avec les litiges passés et présents ?

Dans notre thèse, donc, nous démontrons que les contrats d’accès ou licences à un corpus d’œuvres numériques négociées par des réseaux de bibliothèques auprès des titulaires mènent à l’émergence de nouvelles normes juridiques – les droits d’accès ou droits d’utilisation – ayant trait avec le droit de mise à disposition numérique ou de communication par télécommunication dans les réseaux numériques, un nouveau droit patrimonial introduit par les réformes du gouvernement Harper en 2012. De plus, nous démontrons que les termes de ces licences chevauchent les exceptions édictées par le législateur, qu’il s’agisse de l’utilisation équitable ou des exceptions spécifiques des établissements d’enseignement. En réalité, les bibliothèques ont articulé leur contrat moral, au sens de l’internormativité de Belley, dans des contrats normalisé – où les clauses contractuelles sont représentées dans des systèmes informatiques comme une série de métadonnées. La fonction de ces informations consiste à habiliter les utilisateurs de ces collections numériques à respecter les normes locales édictées par le droit d’auteur. Qui plus est, les exceptions au droit d’auteur, édictées par le législateur canadien, sont également la manifestation du contrat moral des bibliothèques, dans un autre contexte normatif.

La distinction entre les licences numériques et les exceptions au droit d’auteur se comprennent non pas comme une « frontière » (comme nous l’avions proposé comme objectif secondaire de recherche), mais comme un miroir : les unes étant le reflet des autres et opèrent dans deux sphères juridiques distinctes, celles du positivisme et du pluralisme juridique.

Par le fait même, en plus de la théorisation du rôle des bibliothèques dans les systèmes socioéconomiques du droit d’auteur, nous examinons en profondeur l’épistémologie juridique par le biais de l’analyse économique du droit, surtout dans un contexte de droit privé, ainsi que de la sociologie du droit, surtout par le pluralisme juridique. Nous réconcilions ces deux théories juridiques fécondes grâce à un cadre d’analyse novateur.

Dans un premier temps, la doxa économique, dont l’école néoclassique et néolibérale sont les porte-étendards, met l’emphase sur l’analyse des transactions en vue de la maximisation des valeurs produites par les marchés. Cette approche, dont est empreinte l’analyse économique du droit contemporaine, pose comme exogène à la transaction des facteurs qui nous importent, comme le rôle du droit, de la technologie et des pratiques sociales dans la formation des marchés. Cette lacune épistémologique laisse de côté, entre autres, les externalités et les défaillances de marchés comme étant des variables résiduelles à éliminer des beaux modèles économétriques. C’est justement à l’intérieur de ces valeurs résiduelles qu’opèrent la mission sociale des bibliothèques et des questions qui nous animent. Nous avons dû chercher ailleurs pour résoudre cette lacune de la science économique moderne.

Dans un second temps, la sociologie du droit propose justement une image miroir de plusieurs concepts économiques importants. Les marchés deviennent les systèmes sociaux, la cybernétique et les réseaux. La transaction économique évoque l’interaction. Idem pour les agents économiques et les acteurs sociaux; le capital et le pouvoir; la valeur et la légitimité; les institutions; le risque… En droit, l’internormativité de Belley, qui théorise le chevauchement et l’interaction des normes dans un environnement donné, ainsi que les aires de partage et la gestion des risques des données personnelles de Trudel font émerger le point d’encrage dont nous avons besoin, où le droit harmonise l’économie et la sociologie.

Ainsi, nous avons conjugué les éléments de notre modèle théorique, c’est-à-dire comment notre objet d’étude, les droits patrimoniaux des œuvres numériques protégées par le droit d’auteur, se combinent à nos sujets d’étude, les utilisateurs (ou utilisations) de celles-ci dans une pluralité de cadre juridiques, qu’ils soient privés ou publics. Grâce à ce Cadre d’analyse socioéconomique™ ou CASE™, nous opérationnalisons notre cadre théorique dans le contexte précis du droit d’auteur avec la Matrice Œuvres-Utilisations™ ou MŒU™. Cette matrice se présente comme un tableau, où, d’un côté, les lignes représentent toutes les classes homogènes d’œuvres protégées en ce qui concerne leur statut ou état juridique. De l’autre, les colonnes représentent tous les usages homogènes de celles-ci, encore du point de vue juridique. Chacune ces cellules deviennent l’occasion pour une communauté de se positionner face aux paradoxes et instruments juridiques du monde numérique.

Si le CASE est notre contribution originale en droit, alors le MŒU l’est pour la bibliothéconomie. Dans les deux cas, elle s’applique particulièrement bien dans les contextes numériques, où une pluralité d’objets, de sujets et de cadres juridiques se chevauchent, interagissent et éventuellement, se nuisent. Ils s’inscrivent à la frontière du droit public et privé et offre un bagage théorique pertinent en téléologie juridique, utile pour l’interprétation des lois et des situations complexes.

ANECDOTE : Nous avons testé la CASE et la MŒU en 2014 afin de concevoir un document d’information intitulé Foire aux questions pour le droit d’auteur en milieu scolaire suite à un chantier de deux ans sous l’égide de l’Association pour la promotion des services documentaires en milieu scolaire (APSDS). Travaillant avec un comité de bibliothécaires scolaires, nous avons testé la MŒU pour façonner l’appropriation licite et légitime d’œuvres protégées par le droit d’auteur en milieu scolaire.

En outre, ce cadre théorique, opérationnalisé en cadre d’analyse, nous a enfin permit de répondre à nos objectifs de recherche. La matrice œuvres-utilisations est un outil pour organiser un chantier qui permet d’observer l’émergence de normes dans les systèmes économiques et sociaux d’œuvres numériques protégées par le droit d’auteur.

D’ailleurs, la théorie des communs de Hess et Ostrom ainsi que les travaux de Elkin-Koren et Salzberger sur l’école néoinstitutionnelle dans l’analyse économique du droit confirment, à divers égards, l’intérêt d’harmoniser l’économie et la sociologie par le droit grâce à un cadre théorique et opératoire novateur. Nous appliquons la matrice œuvre-utilisation à un contexte précis, celui des pratiques contractuelles des bibliothèques universitaires québécoises dans l’acquisition de contenu numérique pour leurs collections. (Souvenez-vous de l’importance du numérique dans la constitution de nos collections – le numérique représente les trois quarts de nos budgets.) Plus précisément, nous explorons le cadre juridique d’une classe homogène d’œuvres, les écrits numériques obtenus sous licence par les bibliothèques universitaires au Québec, dans un contexte homogène d’utilisation, celui de la recherche, l’étude et l’enseignement.

Pour ce faire, nous nous basons sur le travail de dépouillement des clauses contractuelles par les bibliothécaires universitaires. En effet, les professionnels de l’information ont coordonné leurs efforts depuis les vingt dernières années pour établir les clauses dirimantes ou les clauses souhaitées aux licences. Ensuite, ils ont bâti des systèmes informatiques pour représenter le contenu de ces licences et faciliter la gestion des services pour la communauté. Certains gabarits de données de licences se sont imposés, dont celui développé par les bibliothèques universitaires en Ontario. Ce schéma de métadonnées se présente comme onze questions dont les réponses ne peuvent être que « oui, » « non, » ou « demander. » Dans ce dernier cas, la licence exige des modalités plus complexe que le simple contexte de la question. Ainsi, une utilisatrice de la collection numérique sous licence peut aisément savoir si elle peut verser un document dans un environnement numérique d’apprentissage, le faire suivre par courriel ou se limiter à utiliser un lien vers ledit document. Un exemple d’une instance de licence est fourni aux Figures 3 et 4 de la page 208.

Afin d’étudier l’émergence de normes, nous avons fait suivre des demandes d’accès à l’information à tous les établissements d’enseignement supérieur du Québec leur demandant de nous faire parvenir toutes les instances correspondant à ce schéma de métadonnées. Nous avons obtenu 761 lignes de données – pour autant de licences – de la part de 5 Universités. Le détail se trouve au Tableau 2 de la page 221. Dans un premier temps, nous avons constaté que les licences négociées en consortium représentent moins de variabilité que celles négociées individuellement. Ainsi, les trois combinaisons de clauses contractuelles les plus populaires regroupent plus de la moitié de toutes les instances de licences négociées en consortium tandis que les trois combinaisons les plus populaires des licences négociées individuellement n’en compte que le tiers. Par ailleurs, il existe 29 combinaisons pour les licences en consortium tandis que celles négociées individuellement offrent 87 permutations. Sans tomber dans une avalanche de statistiques comparatives, nous sommes confiants que le recensement des clauses de ces licences offre une feuille de route pour faciliter la tâche aux titulaires désirant offrir leurs corpus aux bibliothèques universitaires.

Grâce à cette étude, nous tirons trois conclusion.

La première démontre l’importance des métadonnées juridiques dans l’automatisation et l’informatisation des rapports socioéconomiques. En quelque sorte, la représentation du contenu normatif des licences projette et rend accessible avec minutie le cadre juridique applicable dans une situation particulière lorsqu’un individu accède à un document. La création de schéma de métadonnées, le dépouillement de licences et la diffusion des données imposent une institutionnalisation et une instrumentalisation qui est transposable à tant d’autres domaines.

La seconde conclusion confirme la symbiose entre une œuvre numérique et son droit d’utilisation: l’un n’a pas de valeur sans l’autre. Dit autrement, il est clair, suite à notre étude, que tous les documents numériques acquis par une bibliothèque le sont sous licence, où sont précisés les droits d’utilisation. Ainsi, la valeur d’un corpus numérique est directement liée à la présence de documents et de droits. Ce constat laisse songeur quant au rôle de la gestion collective lorsqu’une proportion grandissante des collections des bibliothèques universitaires sont en format numérique, donc sous licence et avec des droits d’accès.

La troisième conclusion concerne le rôle des exceptions dans le contexte des licences. Les exceptions et licences numériques découlent toutes deux du contrat moral des bibliothèques. Notre étude confirme que les licences numériques sont en fait la manifestation de celle-ci en contrat normalisé. Ainsi, les exceptions ne servent pas à éliminer le recours aux licences mais à signaler l’importance de la mission morale des bibliothèques en droit positif. En ce qui concerne le pluralisme, le contrat moral des bibliothèques se voit normalisé et introduit une nouvelle façon de concevoir le rôle des exceptions. En effet, il est plus efficace pour une bibliothèque d’obtenir une œuvre numérique sous licence d’un éditeur que de la numériser elle-même grâce à une exception. Cette conclusion introduit une nouvelle façon de concevoir la relation entre les titulaires et les bibliothèques.

Quels chantiers s’ouvrent à nous suite à ces conclusions?

Dans un premier temps, l’importance des métadonnées juridiques nous incite à réfléchir aux rôles des systèmes informatiques complexes dans la gestion des activités socioéconomiques. Spécifiquement, nous croyons que les cryptomonnaies sont un domaine d’intérêt pour le droit cybernétique en général et le droit d’auteur numérique en particulier.

Ensuite, la symbiose entre l’œuvre numérique et ses droits d’accès sous licence, surtout dans le contexte des bibliothèques, nous incite à approfondir la théorie des communs en droit, surtout dans les systèmes sociaux basés sur les contributions volontaires et les licences libres. En effet, serait-il possible de mieux qualifier ce genre de système socioéconomique en droit civil? Comment pouvons-nous expliciter en droit des échanges à large échelle où il n’y a pas toujours des échanges monétaires? Quels seraient les rôles des bibliothèques dans de tels systèmes ?

Puis, l’introduction de nouvelles conceptualisation du cadre juridique des bibliothèques et du rôle des ententes privées nous incite à explorer les liens entre les théories du design participatif et des jeux avec le pluralisme juridique. Justement, s’il est maintenant possible d’articuler des ententes pérennes, évolutives et flexibles, comment est-ce que le design participatif, le co-design et les jeux peuvent-il renseigner le pluralisme dans l’élaboration de rapports juridiques privés? L’idée, bien sûr, consiste à réfléchir aux cycles de vies des objets et sujets au sein de cadres juridiques afin d’anticiper les externalités et les asymétries de pouvoir pour limiter l’intervention du législateur ou des cours dans les rapports socioéconomiques.

Enfin, notre cadre d’analyse socioéconomique ainsi que notre approche quantitative en droit nous confirme l’importance d’une vision téléologique du droit. De plus, nous avons noté que l’analyse empirique et quantitative du droit comme courant intellectuel et académique est de plus en plus populaire. Nous croyons que le cadre d’analyse socioéconomique serait plus que pertinent pour contribuer à ces chantiers intellectuels nouveau du droit. Spécifiquement, nos travaux sur le projet des dictionnaires en accès libre du Centre Paul-André Crépeau de droit privé et comparé à l’Université McGill, ouvrent la porte à une analyse empirique et quantitative du droit. La jurilinguistique est maintenant intimement liée aux algorithmes apprenants et à l’intelligence artificielle. Nous croyons pouvoir adapter notre Cadre d’analyse socioéconomique pour ce sujet brûlant en droit.

Pour conclure, nous croyons que le droit – avec la philosophie, les beaux-arts et la théologie – sont les doyennes des disciplines intellectuelles. Le droit a longtemps tenté de se distinguer de ses vieilles sœurs en revêtant des allures austères et fastidieuses, se repliant tranquillement sur lui-même. L’économie et la sociologie, progéniture du droit nourries par la postmodernité numérique, ont rapidement pris le devant. Il est grand temps que le droit redevienne le point d’encrage entre la sociologie et l’économie, pour focaliser les concepts qui les sous-tendent et pour amener une harmonisation théorique.

Merci.

Exceptions au droit d'auteur Livre et édition Pétition Québec Revendication Utilisation équitable

Pourquoi je vais m’exclure du recours collectif de Copibec c. l’Université Laval

Olivier Charbonneau 2017-09-08

À titre d’auteur de textes publiés, je me qualifie comme membre au recours collectif de Copibec c. l’Université Laval. Je vais envoyer le formulaire de désistement pour m’exclure du recours collectif au greffier de la cour et à l’adresse de Copibec avant le 15 octobre. Je désire, dans les paragraphes qui suivent, expliquer quelques arguments qui motivent mon geste, que je désire être un appui envers l’Université Laval.

Avant de continuer, j’invite la communauté universitaire à se joindre à moi et de s’exclure du recours collectif. Pour ce faire, il suffit d’envoyer formulaire disponible sur le site de Copibec au greffier de la cour – l’adresse postale y est indiquée:

http://copibec.ca/medias/files/Action_collective/Formulaire-exclusion.pdf

Mon geste est motivé par deux raisons : ce recours ignore des réalités commerciales du milieu académique et s’avère une entrave sévère à la liberté intellectuelle et académique, des dimensions de la liberté d’expression.

1. Réalités commerciales de l’édition académique

Malgré ce que Copibec reproche à l’Université Laval, celle-ci a dépensé en 2014-15 pour 12,6 millions de dollars en sources documentaires, dépassée au Québec uniquement par McGill (à 18,9 millions de dollars). À titre de référence, les universités du Québec ont dépensé plus de 63 millions de dollars en ressources documentaires, tandis que le montant s’élève à 311 millions pour toutes celles du Canada. Quant à elles, les bibliothèques publiques du Québec dépensent une trentaine de millions de dollars et les ménages québécois dépensent plus d’un milliard en livres, journaux et revues. Plus des deux tiers de ces fonds servaient (70% pour le Québec), en 2012-2013, à l’acquisition de collections numériques (le BCI ne distingue plus entre l’imprimé et le numérique dans ses statistiques annuelles tant le numérique prend la part du lion des budgets d’acquisition).

La différence fondamentale entre une collection imprimée et une collection numérique est simple à comprendre. Une collection numérique est acquise sous licence, où sont stipulés les droits d’utilisation comme la photocopie et la diffusion aux étudiants par les environnements d’apprentissage numérique. Pour l’imprimé, il faut se fier à la loi et aux licences des sociétés de gestion collective. Ces dernières années, les éditeurs scientifiques ont par ailleurs offert des bouquets numériques des collections déjà acquises en format papier – surtout pour les revues scientifiques. Oui, les bibliothèques universitaires ont acheté de nouveau en numérique une partie non-négligeable de ce qu’elles possédaient déjà en format papier.

Ainsi, la proportion de l’imprimé (nécessitant une licence Copibec) fond dans les acquisitions régulières d’une bibliothèque universitaire québécoise moyenne. La part du numérique, acquis avec une licence qui s’apparente à ce que Copibec offre, explose. Et la nouvelle donne implique que le droit d’accès, introduit par le législateur en 2012 au profit de l’industrie, s’opère avec une licence pour utiliser une œuvre numérique.

En fait, le consommateur de contenu numérique vit la même réalité : toutes les plateformes offrant des œuvres protégées par le droit d’auteur en format numérique le font toujours après avoir consenti à une licence numérique. Vous lisez un livre sur Kindle? Vous avez dit oui à Amazon. Idem pour Netflix, iTunes, Google Play, Steam… Les citoyens ont le loisir d’ignorer les termes de ces licences, les professionnels de l’information – vos bibliothécaires, technicien.ne.s en documentation et commis qui travaillent dans l’ombre – elles, les lisent et les négocient en votre nom.

Résumons la situation avec l’équation suivante. Peu importe le format ou le type de contenu :

Utilisation = document + droit

Dans le monde papier, l’équation était :

Recueils de cours vendus aux étudiants =

collection papier d’une bibliothèque universitaire

+ licence Copibec

Dans le monde de l’édition savante numérique, la réalité que je vis et que j’ai étudiée est :

Utilisation =

document numérique directement de l’éditeur

+ licence d’utilisation directement de l’éditeur

(Souvenez-vous que les bibliothèques ont migré leurs collections vers le numérique et acquièrent massivement des collections numériques)

Notez que sans la licence d’utilisation de l’éditeur, il est IMPOSSIBLE d’acquérir un document numérique. Il ne faut pas la tête à Papineau pour comprendre que la valeur d’une licence avec Copibec, pour une université québécoise moyenne TEND VERS ZÉRO. Pourquoi? Car la proportion d’œuvres proposées dans nos collections sous licence (donc, numériques) explose. En fait, je crois que l’Université Laval est l’une des seules universités québécoises à avoir effectué un travail bibliothéconomique rigoureux. Toutes les autres universités québécoises refilent la facture de la licence Copibec aux étudiants par les frais afférents, donc l’urgence d’attaquer la doxa dominante du droit d’auteur ne se fait pas sentir.

Si j’ose résumer la position de Copibec, l’équation fondamentale de l’accès en bibliothèque serait :

Utilisation =

le document vient d’on ne sait où, peut-être de ce qui reste de la collection papier

+ usurpation des droits d’auteurs par l’utilisation équitable

Cette affirmation comporte une belle fiction qui ne reflète pas la réalité quotidienne de mon travail. Mes recherches doctorales confirment par une analyse empirique ce que je vis au travail.

En fait, le recours à l’utilisation équitable est en soit une exception! Encore évoquant la tête à l’illustre Papineau, un titulaire diligent et raisonnable aura vite compris l’intérêt de ses clients pour le numérique et aurait dû travailler à offrir une solution intéressante… Numériser une œuvre coûte des sous. Imaginez toutes ces universités qui numérisent à la volée dans le cadre d’une exception au droit d’auteur comme l’utilisation équitable – le titulaire pourrait numériser une seule fois et revendre la même copie à toutes les universités… du monde! Il s’agit là d’une des recettes secrètes des gros éditeurs savants du monde.

Si le Parlement Canadien a édicté une panoplie de nouvelles exceptions dans la Loi sur le droit d’auteur en 2012, il a également édicté un nouveau droit au profit des titulaires : celui de rendre accessible dans Internet. Les universités du Québec – et surtout l’Université Laval – ont diligemment suivi le pas du monde de l’édition savante pour embrasser le numérique. Je crois que la faute ne repose pas sur les épaules de l’Université Laval mais que Copibec plaide, en réalité, une forme de turpitude commerciale. De plus, je crois que le milieu culturel transpose sa propre réalité à celle du monde académique. Les externalités et défaillances de marché d’un domaine ne sont pas les mêmes que dans l’autre, bien que le droit d’auteur les gouverne tous.

Il serait plus pertinent de comprendre l’utilisation équitable comme un investissement de la part du secteur public dans l’appropriation des ficelles des marchés et systèmes sociaux qui émergent du numérique. Les bibliothèques universitaires, de concert avec les professeurs, étudiants, technopédagogues et autres collaborateurs, analysent les besoins de leurs clientèles et tentent d’organiser les systèmes économiques et sociaux autour des œuvres numériques. Nous transférons cette connaissance à l’industrie par le biais de licences négociées ou par les exceptions. Dans les deux cas, l’opportunité appartient à celle qui capte le message et s’adapte en conséquence. Copibec devrait proposer une offre commerciale en lien avec nos besoins – actionner les bibliothèques démontre une incompréhension désolante des tendances lourdes du milieu de l’édition savante et des marchés universitaires.

Qu’a fait le cheval face à l’avènement de l’automobile…? Darwin et Schumpeter offrent des pistes de solutions.

Il ne s’agit pas juste de mon évaluation professionnelle de la situation, mais de la conclusion de ma thèse doctorale (que je défendrai le 15 septembre prochain).

2. Liberté intellectuelle et académique, une dimension de la liberté d’expression

J’ai développé le lien entre la liberté intellectuelle, académique et la liberté d’expression dans un chapitre de livre traitant du libre accès, disponible dans le dépôt institutionnel de l’Université Concordia, qui fut publié dans le Handbook of Intellectual Freedom. Tous les auteurs de cette monographie furent primés pour leur travail par la Intellectual Freedom Round Table de la American Library Association. Dans ce texte, je dis:

There is a clear consensus in the literature that intellectual freedom is directly linked with freedom of expression, the press and to access and use information and that it is a core value of librarianship. Gorman famously stated that:

“In the United-States, [intellectual freedom] is constitutionally protected by the First Amendment to the Constitution, which states, in part, “Congress shall make no law respecting an establishment of religion or prohibiting the free exercise thereof; or abridging freedom of speech, or of the press.” There is, of course, no such thing as an absolute freedom outside the pages of fiction and utopian writings, and, for that reason, intellectual freedom is constrained by law in every jurisdiction.” (2000, p. 88)

Gorman continues to state that rarely are proponents “for” or “against” intellectual freedom, but they articulate their views in absolute or relative terms. On these issues, Hauptman (2002 p. 16-29) as well as and McMenemy, Poulter and Burton (2007) offer additional evidence and insight. The link between intellectual freedom and censorship is obvious.

Intellectual freedom is also linked with Article 19 of the United Nation’s Universal Declaration of Human Rights, which states:

“Everyone has the right to freedom of opinion and expression; this right includes freedom to hold opinions without interference and to seek, receive and impart information and ideas through any media and regardless of frontiers.” (1948)

Samek (2007, p. 9-11) provides an account of how various groups, such as United Nations Educational, Scientific and Cultural Organization (UNESCO) and the International Federation of Library Associations and Institutions (IFLA) have further articulated the concept of intellectual freedom in various initiatives and declarations.

Barendt offers an interesting distinction between academic freedom, a well-known right professors enjoy in universities, and intellectual freedom:

“[a]cademic freedom is not identical to intellectual freedom or to freedom of the mind. Intellectual freedom is a right to which we are all entitled, wherever we work. Like freedom of speech or expression, it is a general right belonging to all citizens.” (2010, p. 38)

In discussing how intellectual freedom and freedom of expression are intertwined, Krug further articulates, in light of librarianship, that:

“all people have the right to hold any belief or idea on any subject and to express those beliefs or ideas in whatever form they consider appropriate. The ability to express an idea or a belief is meaningless, however, unless there is an equal commitment to the right of unrestricted access to information and ideas regardless of the communication medium. Intellectual freedom, then, is the right to express one’s ideas and the right of others to be able to read, hear or view them.” (2006, p. 394-5)

From these points, we can draw a common thread for intellectual freedom, namely that it is universal in enshrining our right to access and use information. In light of this, intellectual freedom intersects or overlaps with open access in that the former is promoted as a way to maximize or optimize access and use of digital documents and information while the latter expresses a fundamental right of the same vein.

Je crois que l’action de Copibec, bien que conforme sur le strict point de vue légal, impose un fardeau démesuré et illégitime à nos droits fondamentaux.

3. Annexe statistiques

– Les Universités québécoises, par le biais de leurs bibliothèques, ont dépensé un peu moins de 70 millions de dollars pour l’acquisition de ressources documentaires en 2014-15. (source : BCI)

– Les bibliothèques universitaires canadiennes ont dépensé plus de 311 millions de dollars en acquisitions documentaires (source : CARL/ABRC 2014/15)

– Pour comparer, les ménages québécois ont dépensé 657 millions de dollars en livres (3 milliards au Canada) et 417 millions de dollars en journaux et publications périodiques (un peu moins de 2 milliards an Canada) en 2015 (source : Statistique Canada. Tableau 384-0041 – Dépenses de consommation finale des ménages détaillées, provinciaux et territoriaux, annuel (dollars), CANSIM (base de données). (site consulté : le 7 septembre 2017)

– Pourcentage d’acquisitions en format numérique : L’année 2012-2013 fut la dernière où le sous-comité des bibliothèques du Bureau de coopération interuniversitaire distinguait les dépenses pour les sources numériques et l’imprimé. Il s’élève alors à près du trois-quarts pour le numérique. La part du numérique ne cesse d’augmenter depuis, parole de bibliothécaire universitaire avec plus de 14 ans de métier.

4. Sources

Barendt, E. M. 2010. Academic freedom and the law : A comparative study. Oxford ; Portland, Or.: Hart Pub.

Gorman, Michael. 2000. Our enduring values : Librarianship in the 21st century. Chicago: American Library Association.

Hauptman: préface de Buchanan, Elizabeth A., and Kathrine Henderson, eds. 2009. Case studies in library and information science ethics. Jefferson, N.C.: McFarland & Co.

Krug, Judith F. 2006. Libraries and the internet. Chap. 7.3, In Intellectual freedom manual, ed. Office for Intellectual Freedom. 7th ed., 394. Chicago: American Library Association.

McMenemy, David, Alan Poulter and Paul F. Burton. A handbook of ethical practice : a practical guide to dealing with ethical issues in information and library work. Oxford : Chandos, 2007.

Samek, Toni. 2007. Librarianship and human rights : A twenty-first century guide. Oxford, England: Chandos.

Jugement Québec Revendication

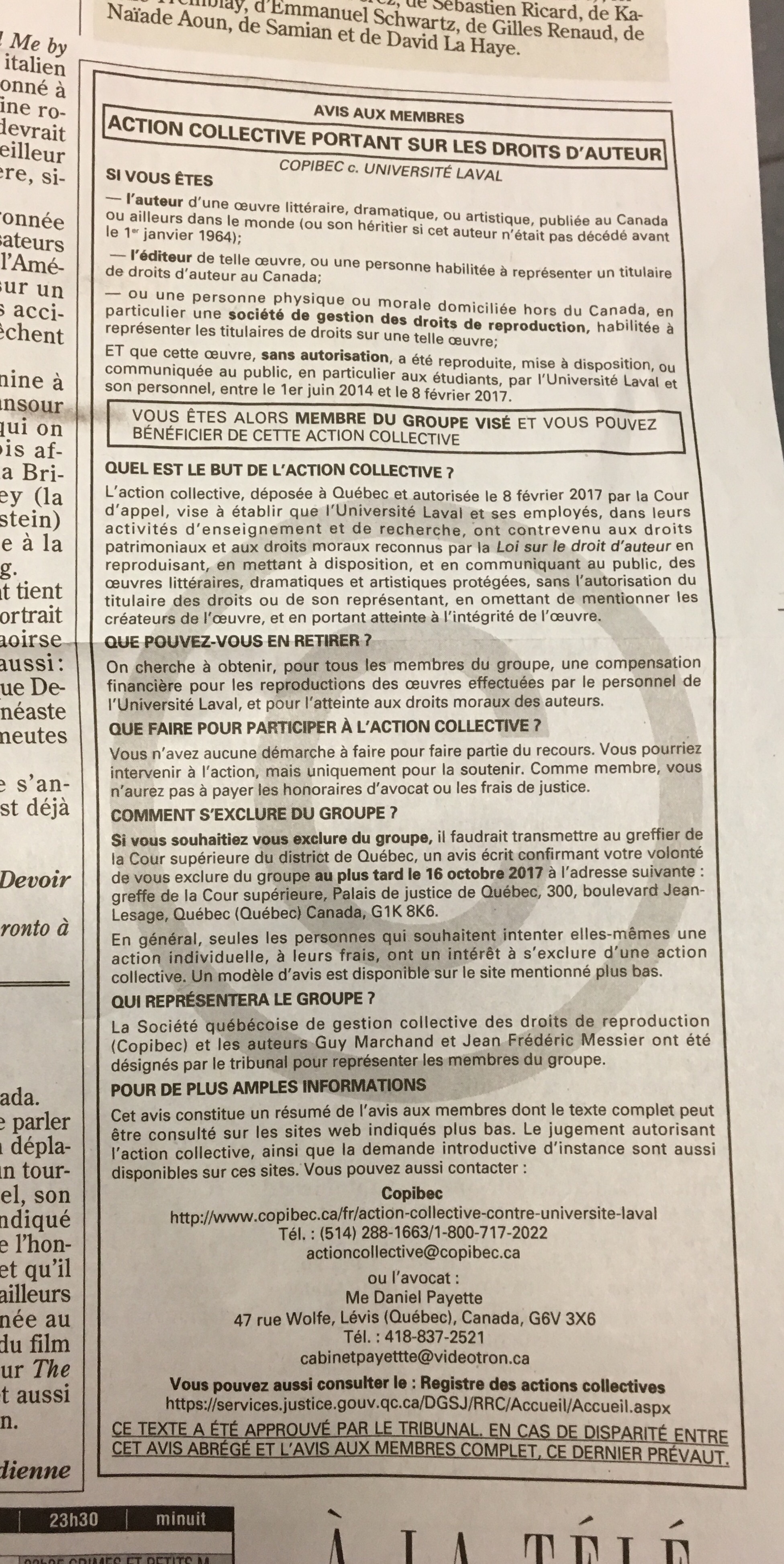

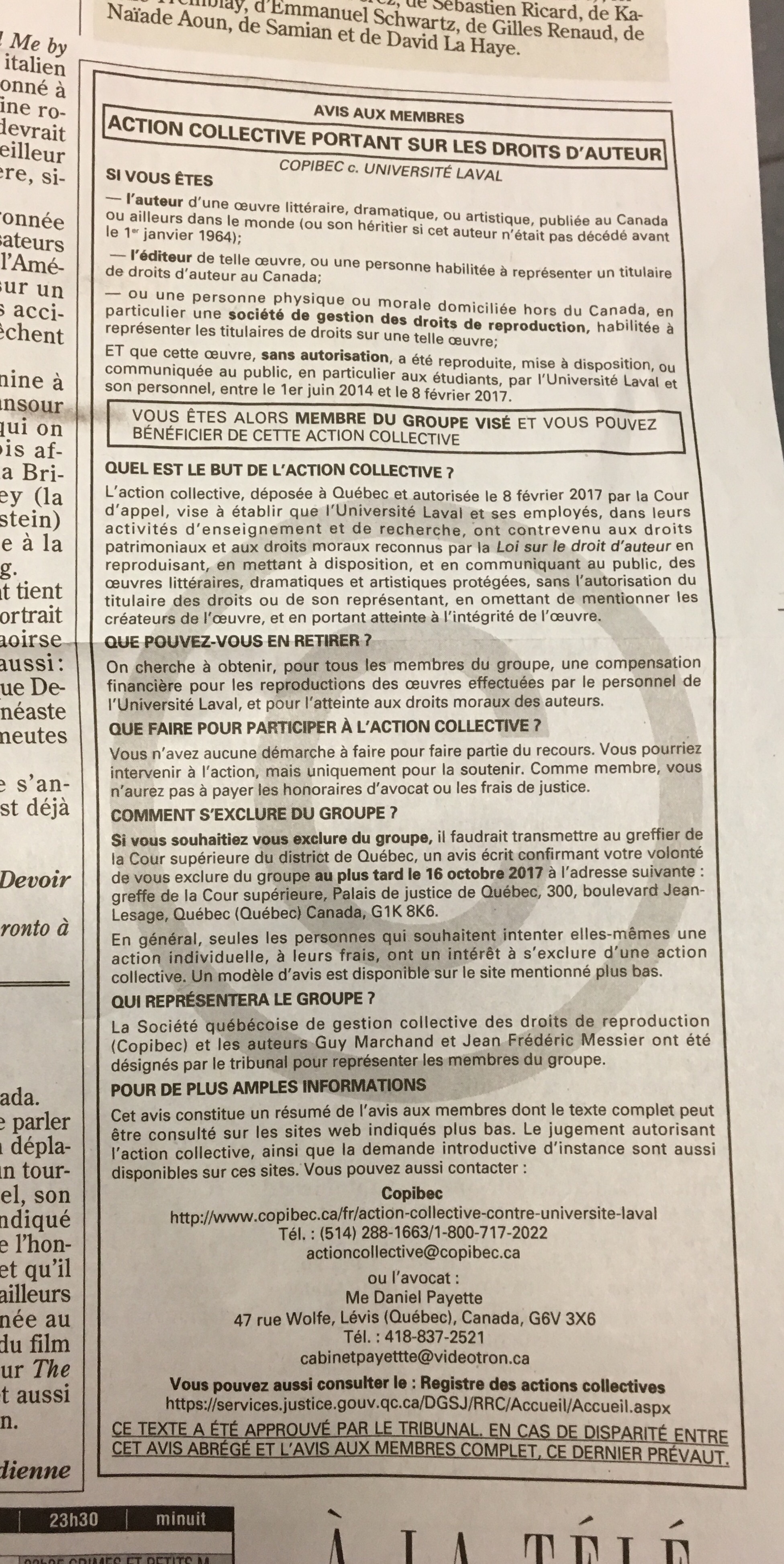

Annonce publique du recours collectif de Copibec c. Université Laval

Olivier Charbonneau 2017-09-07

À la page B7 du quotidien Montréalais Le Devoir apparaît cette annonce de la part de Copibec – cliquez sur l’image si elle ne s’affiche pas correctement :

Cette œuvre protégée par droit d’auteur est reproduite et communiquée au public par télécommunication en vertu du droit à l’utilisation équitable (pour fins de communication de nouvelle, critique, etc.) de l’auteur de ce blogue.

Conférence CultureLibre.ca

Le 15 septembre 2017 à 13h30, aura lieu ma soutenance de ma thèse doctorale

Olivier Charbonneau 2017-08-23

La date de ma soutenance doctorale est le 15 septembre 2017 à 13h30 au local A-3464 (Faculté de droit, Université de Montréal). Son titre est:

Émergence de normes dans les systèmes économiques et sociaux d’oeuvres numériques protégées par droit d’auteur

Mon jury est composé des professeurs suivants:

- Professeur Vincent Gautrais, Université de Montréal, président-rapporteur

- Professeur Pierre Trudel, Université de Montréal, directeur de recherche

- Professeure Pascale Chapdelaine, Université de Windsor, examinatrice externe

- Professeure Marie Demoulin, Université de Montréal, membre du jury

- Professeur Nicolas Vermeys, Université de Montréal, membre du jury

Voici le sommaire:

Pris dans le maelström des révolutions technologiques, de la mondialisation et des revendications de divers groupes sociaux, le droit d’auteur édicte tant bien que mal les dispositions qui règlementent les

systèmes économiques et sociaux où transitent les oeuvres protégées. Notre thèse a comme objectif principal de repérer les normes qui émergent des pratiques de développement des collections numériques par les bibliothèques. Un but accessoire consiste à théoriser sur la « frontière » qui sépare le recours aux licences et le recours aux exceptions du droit d’auteur, tel que l’utilisation équitable. Nous articulons notre cadre

conceptuel et analytique autour de la perspective des utilisateurs d’oeuvres numériques protégées par le droit d’auteur.

La première partie de notre thèse traite de notre objet d’étude : l’oeuvre numérique protégée par droit d’auteur. Nous employons l’analyse économique du droit pour articuler deux axiomes intrinsèquement liés à la nature de l’oeuvre. D’une part, l’oeuvre oscille naturellement entre la nature économique d’un droit de propriété, un bien privé, et la conception utilitariste qui se comprend mieux par les biens publics. Nous nommons cette réalité le paradoxe quantique de l’oeuvre. De l’autre, l’oeuvre change d’un état à l’autre grâce à une multitude d’institutions ou moyens édictés par le droit d’auteur, par exemple : les concessions, les limitations et les exceptions. Si nous ordonnons ces dispositions sur une droite formée par le niveau de risque engendré par chaque utilisation, nous obtenons ce que nous nommons le continuum du consentement, où le risque est inversement proportionnel au consentement du titulaire.

La seconde partie de cette thèse considère les sujets de droit : les agents des systèmes sociaux qui utilisent des oeuvres numériques protégées par le droit d’auteur. Nous étoffons notre cadre conceptuel autour des théories sociologiques du droit, afin d’articuler comment les systèmes sociaux peuvent générer des normes. Pour ce faire, nous puisons dans les nouvelles théories du droit en réseau, de la gestion des risques et de l’internormativité contractuelle. Nous proposons un cadre d’analyse socioéconomique, où se juxtaposent les objets de droit et les sujets de droit. Nous opérationnalisons ce cadre en combinant les éléments de notremodèle dans une matrice oeuvres-utilisateurs où chaque cellule constitue un cadre juridique précis.

La troisième et dernière partie de notre thèse concerne le cadre juridique qui émerge d’un système social particulier, celui des bibliothèques universitaires agissant en réseau grâce à des consortiums d’acquisition.

Nous employons les développements récents en mécanisation et informatisation des rapports contractuels pour analyser le contenu normatif d’une classe de licences d’accès à des oeuvres numériques protégées par droit d’auteur. Les métadonnées représentent le contenu normatif desdites licences et les données d’instances offrent l’occasion d’effectuer des analyses statistiques pour confirmer l’émergence de normes.

Nous concluons que les activités qui mènent à la formation d’ententes d’accès au sein des bibliothèques universitaires au Québec permettent l’émergence de normes dans les systèmes socioéconomiques des oeuvres numériques protégées par le droit d’auteur. Par ailleurs, nous confirmons que ces ententes portent sur des utilisations visées par plusieurs régimes juridiques édictant des exceptions aux droits d’auteur. Nous croyons qu’il s’agit d’un exemple où les institutions emploient des moyens économiques et sociaux pour dépasser le simple cadre juridique édicté par le droit d’auteur et qui vise l’établissement d’un ordre basé sur un contrat social lié à la mission des bibliothèques.

Je diffuserai ma thèse par Internet suite à ma soutenance.

Document numérique Lettres

Avoir la mesure des mots (lecture de Hermeutica de Rockwell & Sinclair, MIT Press 2016)

Olivier Charbonneau 2017-08-23

Suite à mon exploration de l’outil Voyant-tools pour l’analyse textuelle, la Société canadienne des humanités numériques a décerné son prix annuel à Stéfan Sinclair, Professeur à McGill et directeur du centre de recherche sur les humanités numériques, et À Geoffrey Rockwell, professeur de philosophie à l’University of Alberta, pour leur outil Voyant-tools ainsi que leur livre décrivant leur parcours intellectuel intitulé: Hermeneutica : computer-assisted interpretation in the humanities. Je me suis empressé d’emprunter et de lire leur monographie afin de mieux comprendre l’outil qu’ils ont créé…

Les auteurs offrent une réflexion sur leur démarche intellectuelle dans le recours à des outils technologiques pour l’analyse textuelle sourtout dans le domaine des études littéraires. Voici quelques passages qui ont retenu mon attention. Par ailleurs, je cite deux autres livres à la toute fin de ce billet – ils concernent eux aussi le domaine (surtout le livre de Holsti, qui ne figure pas dans la bibliographie de Rockwell & Sinclair mais qui traite d’un sujet très proche).

Je crois que le travail de Rockwell & Sinclair dans Hermeneutica permet de mieux comprendre comment le domaine des études littéraires s’est approprié l’outil informatique. J’espère m’en inspirer largement dans l’analyse empirique et informatique du droit… Selon les auteurs,

This book, to be clear, is not about what we can learn from corpus linguistics or computational linguistics. Rather, it is rooted in the traditions of computer-assisted text analysis in literary studies and other interpretive disciplines and the more hermeneutical ends of philosophy and history. It is about that tradition as much as it is about what you can do with hermeneutical things. Insofar as the tradition of literary text analysis has evolved in parallel with computational linguistics without building on it, we feel justified in leaving that for another project.

The use of interpretive tools in the social sciences is also outside the purview of this book. There is a tradition of qualitative techniques and tools for analyzing interviews or other texts of interest to social scientists. This is similar to literary text analysis, in that it uses computers to interpret texts, but the goals and methods are different. Atlas.ti, NVivo, and similar tools help social scientists with content analysis for social scientific aims. They are not meant to help understand the texts themselves so much as to help understand the phenomena of which texts such as interview transcripts are evidence. Again, as with linguistic analysis, we could learn a lot from such

(p. 19)

tools and traditions of research practice, but they are beyond the scope of this book. (p. 20)

En citant les travaux de Smith, Rockwell & Sinclair tentent de développer une approche théorique basée sur une approche itérative de l’interrogation d’un corpus (p.86-7). Smith a précédé Rockwell & Sinclair de quelques décennies mais fut confronté à la même problématique qu’eux: comment développer une approche méthodologique face à la montagne de données, statistiques, mesures, et autres calculs possibles sur un corpos précis.

In his article “Computer Criticism” Smith completes the move from imagery, as it is manifest in computer visualizations of various kinds, to a critical theory that opens the way for computational methods. What makes this hermeneutical circle even more interesting is that the aesthetic theory voiced by Stephen Dedalus nicely captures the encounter with the visualization. Dedalus has developed an idea from the medieval philosopher Thomas Aquinas. The encounter with art, Dedalus argues, passes through three phases:

1. Integritas: First, the aesthetic image (visual, audible, or literate) is encountered in its wholeness as set off from the rest of the visible universe.

[…]

2. Consonantia: Then one apprehends the harmony of the whole and the parts.

(p. 88)

[…]

3. Claritas: And finally one sees the work in its particular radiance as a unique thing, bounded from the rest but with harmonious parts. […]

These three phases or this aesthetic encounter make a pattern that we can use for the interpretive encounter. The sequence might be something like the following steps, the first two having been outlined in chapter 2 and the third covering how results are returned to you (the subject of this chapter).

Demarcation First, one has to identify and demarcate the text (or corpus) one is going to interpret. In that choice one is defining the boundary of a work or collection from the rest for the purposes of interpretation. Pragmatically this takes the form of choosing a digital text and preparing it for study.

Analysis Second, one breaks the whole into parts and studies how those parts contribute to the form of the whole. Smith, in “Computer Criticism,” suggests that this is where the computer can assist in interpretation. Stephen Dedalus summarizes this as analyzing “according to its form.” 18 The computer can automate the analysis of a text into smaller units (tokens). Even individual words can be identified and be used as the unit for analysis.

Synthesis Third, there is a synthesis of the analytical insights and interpretive moves into a new form that attempts to explain the particular art

of the work being studied. That is the synthesis into visualizations and then into an essay; a new work that attempts to clarify the interpreted work. These syntheses are hermeneutica.

When we return later to theorize computer-assisted interpretation, we will look more closely at Smith’s structuralist critical theory, the weakest part of his triptych of illustrative essay, theory, and tools.

(références pour ce passage)

Smith , J. B. Image and imagery in Joyce’s Portrait: A computer-assisted analysis . In Directions in Literary Criticism: Contemporary Approaches to Literature, ed. S. Weintraub and P. Young . University Park : Pennsylvania State University Press , 1973 .

Smith , J. B. 1978 . Computer criticism. Style 12 ( 4 ): 326 – 356 .

Smith , J. B. 1984 . A new environment for literary analysis. Perspectives in Computing 4 ( 2/3 ): 20 – 31 .

Smith , J. B. 1985 . Arras User’s Manual. TextLab Report TR85-036, Department of Computer Science, University of North Carolina, Chapel Hill.

(Important: Stephen Dedalus est l’aterego littéraire de James Joyce, l’auteur qu’analyse Smith.)

Les auteurs considèrent que l’accessibilité accrue à des corpus numériques et aux outils pour les analyser introduisent des mutations dans leur discupline:

Big data has been trumpeted as the next big thing made possible by the explosion of digital data about us, to which we contribute. As we write this, big data probably is at the high point in the Hype Cycle —there are inflated expectations as to how it will transform business, government, and the academy, and soon there are likely to be more sober evaluations. Drawing on Mayer-Schönberger and Cukier’s book Big Data, we characterize how

big data changes methods as follows:

From samples to comprehensive data In the humanities and the social sciences, traditionally we either focus on works that are considered distinctive or sample larger phenomena. Big data draws on relatively complete datasets, often created for entirely different purposes, and uses them for new research. These datasets are comprehensive in a way that sampling isn’t, and in a way that can change the types of questions asked and can change people’s confidence in the answers.

(p. 125)

From purposeful data to messy and repurposed data Traditionally, the data used in research are carefully gathered and curated for that research. With big data, we repurpose messy data from other sources that weren’t structured for research and we aggregate data from multiple sources. This raises ethical issues when people’s information is used for purposes they didn’t consent to; it also means that we can extract novel insights from old data, which is why preservation of data is important.

From causation to correlation Big data typically can’t be used to prove causal links between phenomena the way experiments can. Instead, big data is used to show correlations. Big data is being pitched as an opportunity to reuse data to explore for new insights in the form of correlations. There are even techniques that can comb through datasets to identify all the statistically significant correlations that could be of research interest.

What Does This Mean for the Humanities?

What does this mean for the humanities in general and the Digital Humanities in particular? Well, there are obvious privacy issues, ethical issues, and governance issues that call for attention. The liberal arts are supposed to prepare free ( liber) people for citizenship and participation in democratic community. Big data is now one way citizens are managed both by industry and by government. 25 The liberal arts clearly have a role in studying and teaching about big data. To get a conversation of the phenomenon going, the researchers danah boyd and Kate Crawford (2012) offer six provocative statements:

1. Big Data changes the definition of knowledge.

2. Claims to objectivity and accuracy are misleading.

3. Bigger data are not always better data.

4. Taken out of context, Big Data loses its meaning.

5. Just because it is accessible does not make it ethical.

6. Limited access to Big Data creates new digital divides.

Following boyd and Crawford, one way to think about big data is to look at the pragmatics of how working with large amounts of data changes knowledge. A particularly Digital Humanities way to do this is to think through experimenting with the analysis of large datasets. “Thinking through” is an approach of understanding a phenomenon (thinking about it) through the practices of making, experimenting, and fiddling. It is one of the ways the Digital Humanities can contribute to the larger dialogue of the humanities through what Tito Orlandi and later Willard McCarty called

(p. 126)

modeling. We create models of systems and learn through the iterative making and reflecting on the models—especially when they fail, as they usually do. The false positives that our hermeneutica throw up tell us about the limitations of our models and hence about the limitations of the theories of knowledge on which they are based.

Ainsi, (p. 128-130)

What Can We Do with Big Data Analytics?

At this point, let us take a quick tour through some of the opportunities and risks for Big Data in the Digital Humanities.

Filtering and subsetting We begin with a basic operation comparable to what intelligence services do with Information in Motion: filtering big data to get useful subsets that can then be studied by other, possibly traditional techniques (e.g., reading). The Cornell Web Lab, which alas was closed in 2011, was working with the Internet Archive to build a system that would enable social scientists (and humanists) to extract subsets from the archive. The dearth of resources that allow for navigation between large databases of content (among them the Gutenberg Project of digital texts) to specialized environments for reading and analysis should be noted here.

Enrichment “Enrichment” is a general term for adding value. In the context of big data, researchers are developing ways to enrich large corpora automatically using the knowledge in big data. In “What Do You Do with a Million Books?” (the 2006 article that first prompted many of us to begin thinking about what big data meant in the humanities), Greg Crane wrote eloquently about what we now can do to enrich big data to make it more useful. Crane has made the further point that simply providing translation enrichment could provide us with a platform for a dialogue among civilizations.

Sequence alignment Sequence alignment can be adapted from bioinformatics for the purpose of following passages through time. This is the research equivalent to what plagiarism detectors do with students’ papers. They look at sequences of text to see whether similar passages can be found in other texts, contemporary or not. Horton, Olsen, and Roe (2010) described work they had done with the ARTFL textbase to track how passages in an influential twentieth-century history by Paul Hazard had been cribbed from a seventeenth-century text. The point is not that Hazard was a lazy note taker, but that one can follow the expression of ideas across writers when one has them in digital form.

Diachronic analysis Diachronic analysis is using data sets to study change over time. Although the use of large diachronic databases dates back to

(p. 129)

the Trésor de la langue française (TLF) and the Thesaurus Linguae Grecae (TLG) projects, diachronic analysis got a lot of attention after Google made its Ngram Viewer available and after Jean-Baptiste Michel and colleagues published their paper “On Quantitative Analysis of Culture Using Millions of Digitized Books” (2010). There are dangers to using Ngrams (or phrases of words) to follow ideas when the very words have changed in meaning, orthography, and use over time, but the Ngram Viewer is nonetheless a powerful tool for testing change in language over time (and its search-and-graph approach makes it accessible to a broad public).

Classification and clustering Classification and clustering comprise a large family of techniques that go under various names and can be used to explore data. Classification and clustering techniques typically workon large collections of documents and allow us to automatically classify the genre of a work or to ask the computer to generate clusters according to specific features and see if they correspond to existing classifications. A related technique, Topic Modeling, identifies clusters of words that could be the major “topics” (distinctive terms that co-occur) of a large collection. An example was given in the previous chapter, where we used correspondence analysis to identify clusters of key words and years in the Humanist archives.

Social network analysis Social network analysis (SNA) involves identifying people and other entities and then analyzing how they are linked in the data. It is popular both in the intelligence community and in the social sciences. SNA techniques can graph a network of people to show how they are connected and to what degree they are connected. In the social sciences, the data underlying a network typically are gathered manually. One might for example interview members of a community in order to understand the network of relationships in that community. The resulting data about the links between people can be visualized or queried by computer. These techniques can be applied in the humanities when one wants to track the connections between characters in a work (Moretti 2013), or the connections between correspondents in a collection of letters or places mentioned in a play. Just as an ethnographer might formally document relationships between people, a historian might be interested in determining who lived in Athens when Socrates was martyred and how those people were connected. Large collectionsof church records, letters, and other documents now allow us to study social networks of the past. Thanks to a new family of techniques that can recognize the names of people, organizations, or places in a text, it is

(p. 130)

now possible to extract named entity data automatically from large text collections, as the Voyant tool called RezoViz does.

Self-tracking Self-tracking is the application of big data to your life. You can gather big data about yourself. Personal surveillance technologies allow you to gather lots of data about where you go and who you correspond with, and to then analyze it. The idea is to “know thyself” better and in more detail (or perhaps just to remind you to exercise more). Though results of self-tracking may not seem to be big data relative to the datasets gathered by the NSA, they can accumulate to the point where one must use mining tools to make sense of it. A fascinating early project in life tracking was Lifestream, started in the 1990s as a project at Yale by Eric Freeman and David Gelernter, which introduced interesting interface ideas about how information could be organized according to the chronological stream of life. 31 Gordon Bell has a project at Microsoft called MyLifeBits that has led to a commercially available camera, the Vicon Revue; you hang it around your neck, and it shoots pictures all day to frame bits of your life. 32 Recently Stephen Wolfram, of Mathematica fame, has posted an interesting blog essay on what he has learned by analyzing data he gathered about his activities—an ongoing process that, he argues, contributes to his self-awareness. 33 Many different tools are now available to enable the rest of us to gather, analyze, and share data about ourselves—especially data on our physical fitness data. (Among those tools are the fitbit, the Nike+ line, 34 and now the Apple Watch.)

Les auteurs (p. 128) proposent les lectures suivantes pour aller plus loin:

Jockers , M. L. 2013 . Macroanalysis: Digital Methods and Literary History. Urbana : University of Illinois Press .

Moretti , F. 2007 . Graphs, Maps, Trees: Abstract Models for Literary History. London : Verso .

Moretti , F. 2013 a. The end of the beginning: A reply to Christopher Prendergast . In Moretti, Distant Reading. London : Verso ,

Moretti , F. 2013 b. Network theory, plot analysis . In Moretti, Distant Reading . London : Verso .

L’analyse de données massives et textuelles amène certains écueils.

The problem is that when you analyze a lot of data you get a lot of false hits or false positives. The messier the data, the more false hits you get. The subtler the questions asked of the data, the more nuanced and even misleading the answers are likely to be. When you use Google to search for someone with a common name, such as John Smith, with big data you can get overwhelmingly big and disappointingly irrelevant results—result sets that are too big for you to go through to find the answer, and therefore not useful. (p. 131)

Par ailleurs,

A second problem with analysis of big data is the dependence on correlation. It doesn’t tell you about what causes what; it tells you only what correlates with what (Mayer-Schönberger and Cukier 2013, chapter 4). With enough data one can get spurious correlations, as there is always something that has the same statistical profile as the phenomenon you are studying. This is the machine equivalent to apophenia, the human tendency to see patterns everywhere, which is akin to what Umberto Eco explores in Interpretation and Overinterpretation (1992).